Künstlicher Intelligenz wird viel Vertrauen entgegengebracht – vielleicht zu viel. KI soll Tumore markieren, bei der Therapie psychisch erkrankter Menschen helfen, Produktionsfehler in Fabriken und Hindernisse beim autonomen Fahren erkennen. Doch sie ist nicht perfekt. Die Liste von Fehlerquellen ist lang. Dank einer Studie von Forschern der TU Berlin ist ein weiterer Eintrag hinzugekommen: Sie beschreibt einen Fehler, der mit dem sogenannten „Kluger-Hans-Effekt“ zusammenhängt.

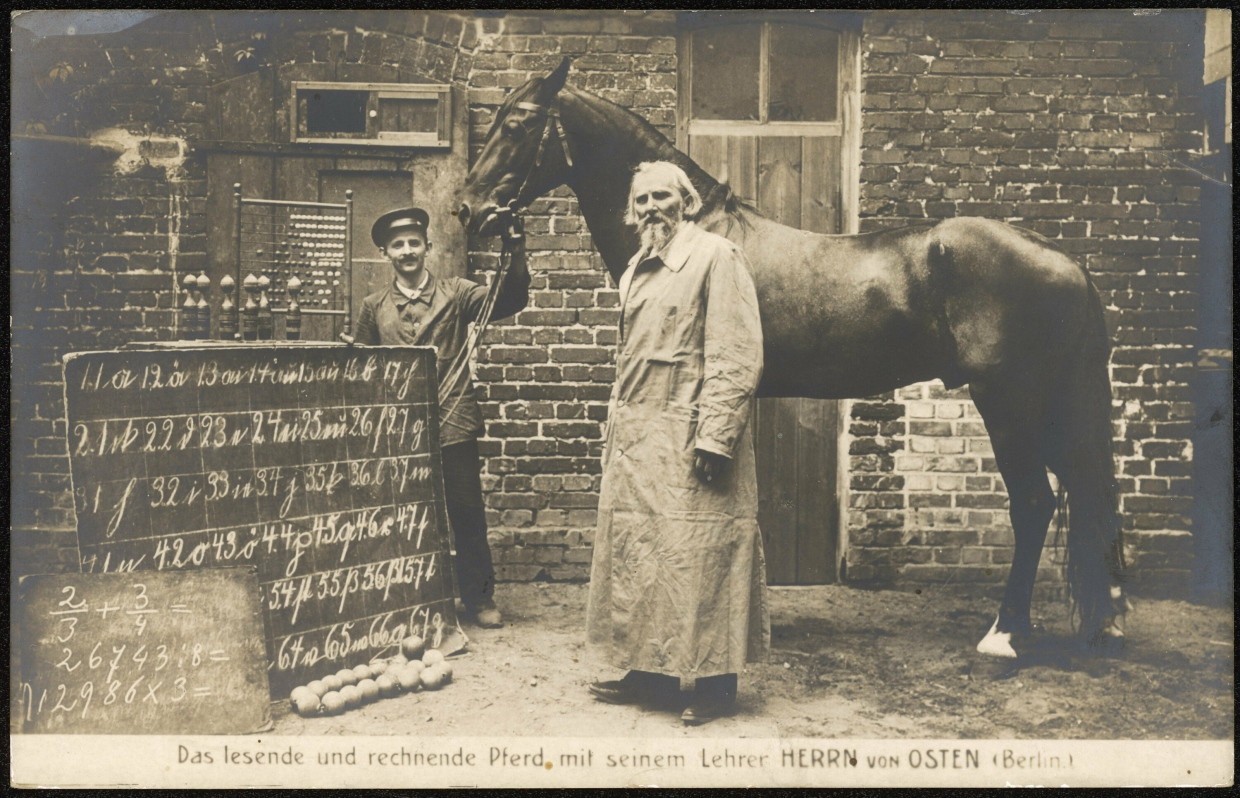

Der Kluge Hans war ein Pferd, das Anfang des 20. Jahrhunderts Rechenaufgaben löste. Seine Antworten teilte es mit, indem es entsprechend häufig aufstampfte. Doch Hans achtete wohl nicht auf die Aufgabe, sondern auf die Körpersprache der menschlichen Fragesteller. Die waren vor dem finalen Aufstampfen angespannt und danach gelöst. So wusste Hans, wann er aufhören muss. Er beantwortete die Frage korrekt, jedoch aus den falschen Gründen.

KI ereknnt vermeintlich Tumore – achtet aber auf Maßstab

Dieser Effekt ist beim sogenannten „überwachten Lernen“ lange bekannt. Dabei trainiert die KI mit von Menschenhand sortierten und beschriebenen Beispielen. Sie bekommt etwa Aufnahmen von Tumoren und Muttermalen und lernt, sie zu unterschieden. Tatsächlich gab es den Fall, dass eine KI dabei gelernt hat, auf den Maßstab, der in den Trainingsdaten nur neben den Tumoren eingeblendet war, als Hinweis zu nutzen. So wie der Kluge Hans kam sie aus falschen Gründen zum richtigen Ergebnis.

Ein anderes System sollte Pferde auf Fotos erkennen – nutzte in Wahrheit aber Hinweise auf ein Pferdefoto-Archiv im Urheberrechtsvermerk. Eine andere KI unterschied Wölfe und Huskys – behalf sich dabei aber mit dem Schnee im Hintergrund der Husky-Fotos. Das Problem ist: Eine solche KI funktioniert vermeintlich. In der echten Welt, wo es nicht immer Copyright-Vermerke und Maßstäbe gibt und wo auch mal ein Husky im Sommer fotografiert wird, versagt sie. Das kann bei Medizinprodukten oder autonomen Autos Leben kosten.

Die Basis vieler KI-Systeme krangt am Kluger-Hans-Effekt

Die Forscher haben diesen Effekt nun beim „unüberwachten Lernen“ nachgewiesen. Diese Methode bildet die Basis vieler heutiger KI-Systeme. Die Idee ist, dass die Modelle nicht mit vorsortierten und beschriebenen Daten lernen, sondern eigenständig nach Zusammenhängen in gigantischen Datenmengen suchen.

Ein solches System namens „PubMedClip“ kann etwa Röntgenbilder beschreiben. Die Forscher betteten es in einen größeren Verbund von KI-Algorithmen ein und ließen es Hinweise für eine Covid-Infektion auf Lungenaufnahmen erkennen. Das testeten sie mit zwei Datensätzen. Beim ersten funktionierte das System gut, doch beim zweiten irrte es sich oft. Weitere Untersuchungen zeigten, dass es von Notizen neben den Aufnahmen irritiert war. Ein System, das Anomalien in Bauteilen erkennt, zeigte ähnliche Schwächen.

Lösungsansätze schaffen das Problem nicht aus der Welt

„Durch Anwendungsfälle aus Medizin und Industrie konnten wir zeigen, dass der Kluge-Hans-Effekt die Leistungsfähigkeit von KI-Modellen verringern kann“, schreiben die Forscher in „Nature Machine Intelligence“. Tatsächlich haben sie damit systematisch einen Fehler nachgewiesen, der in vielen KI-Systemen steckt, die dann in der Industrie oder Medizin Anwendung finden. Daher schlagen sie Methoden vor, um den schädlichen Effekt bereits in den grundlegenden KI-Modellen zu verringern, bevor er sich in Anwendungen schleicht.

Doch das verbesserte die Systeme nur minimal, sagte Marcus Liwicki, KI-Experte der schwedischen Luleå University of Technology, in einem Statement: „Wie immer ist die vorliegende Studie ein wichtiger Schritt, das Problem ist jedoch nicht zu 100 Prozent gelöst.“ Beim Einsatz von KI in kritischen Bereichen würde er ihr ohnehin nie blind vertrauen. „Am besten ist oft immer noch eine Kombination aus beidem, KI und Mensch.“ Natürlich irren sich auch Menschen, aber sie machen andere Fehler als die KI – und fallen nicht auf Schnee im Hintergrund herein, wenn sie einen Husky erkennen sollen.