Künstliche Intelligenz wird in rasantem Tempo schlauer. Ein neuer Wissenstest soll sie jetzt herausfordern. Wenn die KI ihn besteht, kann die Menschheit sich keinen schwereren mehr ausdenken.

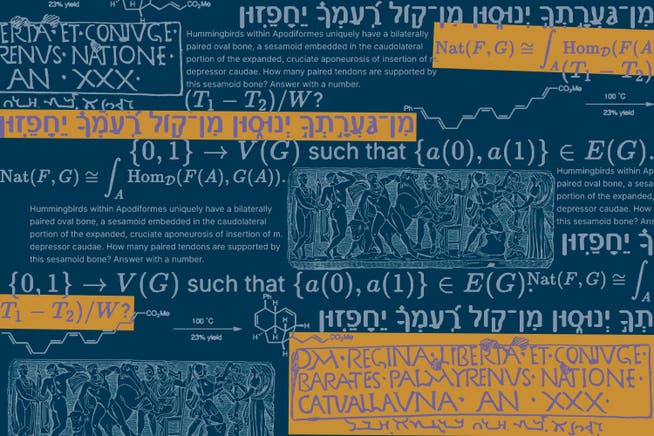

Graphentheorie oder die Übersetzung einer Inschrift im zweitausend Jahre Palmyra-Alphabet: Die KI ist aufs Äusserste gefordert.

Es soll der ultimative Test akademischen Wissens sein, mit den schwierigsten Fragen aus allen Fachgebieten. «Humanity’s Last Exam» nennen ihn die Forscher, die letzte Prüfung der Menschheit. Denn eine nächste, noch schwerere Prüfung für KI zu entwickeln, sei für Menschen unmöglich.

Vor zwei Jahren noch rasselte selbst die damals weltbeste KI durch das deutsche Abitur. Doch die Fähigkeiten von KI-Modellen sind seither rasant gestiegen. Das Abitur oder die Matura sind längst keine Herausforderung mehr für sie, die Aufnahmetests der renommiertesten Universitäten bestehen sie mit Leichtigkeit, und auch speziell für KI entwickelte Tests lösen die modernen Chatbots zunehmend mit Bestnoten.

Das stellt KI-Entwickler vor ein Problem. Denn um den Fortschritt der KI-Entwicklung zu messen und verschiedene Chatbots zu vergleichen, braucht es Tests, die diese an ihre Grenzen bringen.

Eine Herausforderung für Menschen und KI

Forscher am amerikanischen Zentrum für KI-Sicherheit haben deshalb eine neue Prüfung für KI entwickelt. Einer der Entwickler der Prüfung ist der amerikanische KI-Forscher Dan Hendrycks. Gegenüber der «New York Times» hat er verraten, dass die Idee in einem Gespräch mit Elon Musk entstanden sei. Die etablierten Tests deckten Wissen auf dem Level von Bachelor-Studenten ab, soll Musk gesagt haben. Er wünsche sich einen Test auf dem Niveau von Weltklasse-Experten.

Also haben Hendrycks und sein Team über tausend Experten für die verschiedensten Fachrichtungen aus mehr als fünfzig Ländern kontaktiert. Sie sollten die schwierigsten Fragen einsenden, die ihnen in ihrem jeweiligen Fachgebiet einfallen. Die Fragen mussten eine eindeutige richtige Antwort haben und sollten sich nicht durch eine schlichte Internetsuche beantworten lassen.

Das Resultat ist ein Fragenkatalog, der so divers wie anspruchsvoll ist. «Humanity’s Last Exam» besteht aus insgesamt 3000 Fragen. Es geht um Mathematik, Physik und Biologie, aber auch Geisteswissenschaften und sogar Schachtaktik werden abgefragt. Es gibt Fragen zur anatomischen Funktion eines winzigen Knöchelchens in der Brust von Kolibris, zur Übersetzung einer Inschrift im zweitausend Jahre alten Palmyra-Alphabet, zu Graphentheorie, elektrozyklischen Reaktionen und Spannungsvektoren. Um hier zu brillieren, müsste man ein Universalgelehrter im Stile Leonardo da Vincis sein – doch mit dem gesammelten Wissen der Menschheit von heute statt dem von vor 500 Jahren.

Eine Prüfungsfrage verlangt nach der Übersetzung einer römischen Inschrift, die zum Teil in einem jahrtausendealten Alphabet verfasst ist.

Tatsächlich fielen die Resultate der KI-Modelle schlecht aus. Als die Wissenschafter den neuen Test Ende Januar erstmals veröffentlichten, konnten die modernsten Chatbots wie Chat-GPT o1, Grok 2 oder Deepseek R1 allesamt nur wenige Prozent der Aufgaben richtig lösen. Die Herausgeber des Tests rechnen damit, dass es etwa ein Jahr dauern wird, bis der erste Chatbot mehr als die Hälfte der Fragen korrekt beantworten kann.

Kaum zwei Wochen später war diese Vorhersage bereits veraltet und klang unnötig pessimistisch. Denn Open AI hat einen neuen Chatbot veröffentlicht, der für besonders komplexe Themen und Fragestellungen optimiert ist. «Deep Research» heisst das neue Produkt. Statt innerhalb weniger Sekunden eine Antwort zu generieren, lässt der neue Chatbot sich bis zu einer halben Stunde lang Zeit. Er greift auf das Internet zu, sucht auf verschiedenen Websites Informationen zusammen, kann programmieren. Und beantwortet laut Sam Altman, dem CEO von Open AI, 26 Prozent aller Fragen in «Humanity’s Last Exam» richtig.

Wissen bedeutet nicht Intelligenz

Sam Altman, Elon Musk und Co. sehen eine hohe Punktzahl in «Humanity’s Last Exam» als Zeichen, dass die Entwicklung einer allgemeinen künstlichen Intelligenz (AGI) kurz bevorsteht. So bezeichnen sie eine KI, die genauso intelligent, flexibel und vielseitig ist wie ein Mensch – oder gar noch intelligenter. Eine allgemeine künstliche Intelligenz soll laut Altman einen Grossteil der ökonomisch wertvollen Arbeit besser erledigen können als Menschen. Mit diesem Versprechen rechtfertigt er gegenüber seinen Investoren die enormen Summen, die die Weiterentwicklung von KI verschlingt.

Doch so beeindruckend es ist, wenn KI Prüfungsfragen auf Experten-Niveau beantworten kann: Die Punktzahl in «Humanity’s Last Exam» ist keineswegs ein Anhaltspunkt für die Intelligenz einer KI. Denn der Test fragt Wissen ab, nicht logisches Denken, und erst recht nicht Kreativität oder die Fähigkeit, neue Gedanken zu entwickeln. So betonen auch die Herausgeber von «Humanity’s Last Exam» selbst, dass ihr Test zwar in Wissensfragen die letzte Prüfung sein soll, aber sicher nicht der letzte Test für KI generell bleiben wird.

Ein Test, der so etwas wie die Intelligenz einer KI besser misst, ist die «Abstract Reasoning Challenge» von François Chollet. Er ist darauf ausgerichtet, logisches und abstraktes Denken zu testen. Um die Aufgaben zu lösen, muss die KI in der Lage sein, kausale Zusammenhänge zu erkennen. Nur so kann sie wie hier im Beispiel die Bilderreihen logisch ergänzen:

Bei diesem Beispiel wird jeweils der blaue Strich in Grün verlängert, bis er an der roten «Wand» abprallt.

Was für Menschen einfach ist, war für KI lange eine grosse Herausforderung. Es scheint allerdings, als hätte KI auch diese Hürde kürzlich genommen. Die neuste Chat-GPT-Version von Open AI löst 88 Prozent der logischen Rätsel korrekt.

Chollet hat eine eigene Definition von allgemeiner künstlicher Intelligenz: «Wir werden wissen, dass AGI hier ist, wenn es schlichtweg unmöglich wird, einen Test zu entwickeln, der für Menschen einfach, aber für KI schwierig ist», schreibt er auf seinem Blog. Er arbeitet bereits an einer neuen, schwierigeren Version der «Abstract Reasoning Challenge». Noch ist er zuversichtlich, dass die KI-Modelle an seinem neuen Test scheitern werden, während «ein schlauer Mensch» über 95 Prozent der Fragen beantworten kann. Aber wie viele schwierigere Tests können danach noch kommen? Muss Chollet bald den «letzten Logiktest der Menschheit» veröffentlichen?

Die Chatbots halluzinieren noch immer

Noch ist der Punkt jedenfalls nicht erreicht, an dem kein Test der KI mehr schwer genug ist. Und es gibt noch grundlegende Probleme zu lösen.

Auch das zeigen die Ergebnisse von «Humanity’s Last Exam». Denn neben der Anzahl richtiger Antworten messen die Forscher im Test auch, wie sicher sich ein Chatbot bei seinen Antworten ist. Es zeigt sich: Obwohl sie den Grossteil der Fragen falsch beantworten, geben die Chatbots bei mehr als 90 Prozent ihrer Antworten an, dass sie sich sehr sicher sind. Eigene Fehler zu erkennen und eingestehen zu können, scheint also noch ein Feld zu sein, in dem der Mensch der Maschine deutlich voraus ist.

Für Nutzer sind diese Halluzinationen ein grosses Problem. Denn solange KI selbstbewusst falsche Fakten verkündet, können sie ihren Resultaten nicht vertrauen. Daher ist es sehr relevant, dass die Forscher die Häufigkeit und Schwere von Halluzinationen in «Humanity’s Last Exam» explizit erfassen. Das dürfte KI-Entwicklern einen Anreiz geben, die Halluzinationen in der nächsten Generation von KI-Modellen zu reduzieren.

Womöglich sollten Entwickler diese Kenngrösse noch ernster nehmen als die reine Anzahl richtiger Antworten. Denn die meisten Nutzer würden sich wohl eher für das KI-Modell entscheiden, das am wenigsten Fakten erfindet, als für das Modell, das die Anatomie eines Kolibris am genausten kennt.

Ein Artikel aus der «»