Künstliche Intelligenz wird immer mächtiger – und damit auch gefährlicher. Ein Experte erklärt, warum US-Konzerne die Regulierung verwässern wollen – und was auf dem Spiel steht.

Vor anderthalb Jahren wurde mit dem AI Act von der EU das weltweit erste umfassende KI-Gesetz verabschiedet. Doch die konkreten Regeln für die stärksten KI-Systeme wie ChatGPT, Gemini oder Claude sind darin nur grob skizziert. Deshalb arbeitet die EU-Kommission seit Monaten an einem detaillierten Verhaltenskodex (Code of Conduct), der festlegt, wie sich Tech-Konzerne genau verhalten müssen. Hinter den Kulissen wird ein intensiver Lobbykampf von US-Tech-Giganten wie OpenAI, Google und Meta geführt, die sich gegen strengere Anforderungen und europäische Regulierungsbehörden wehren.

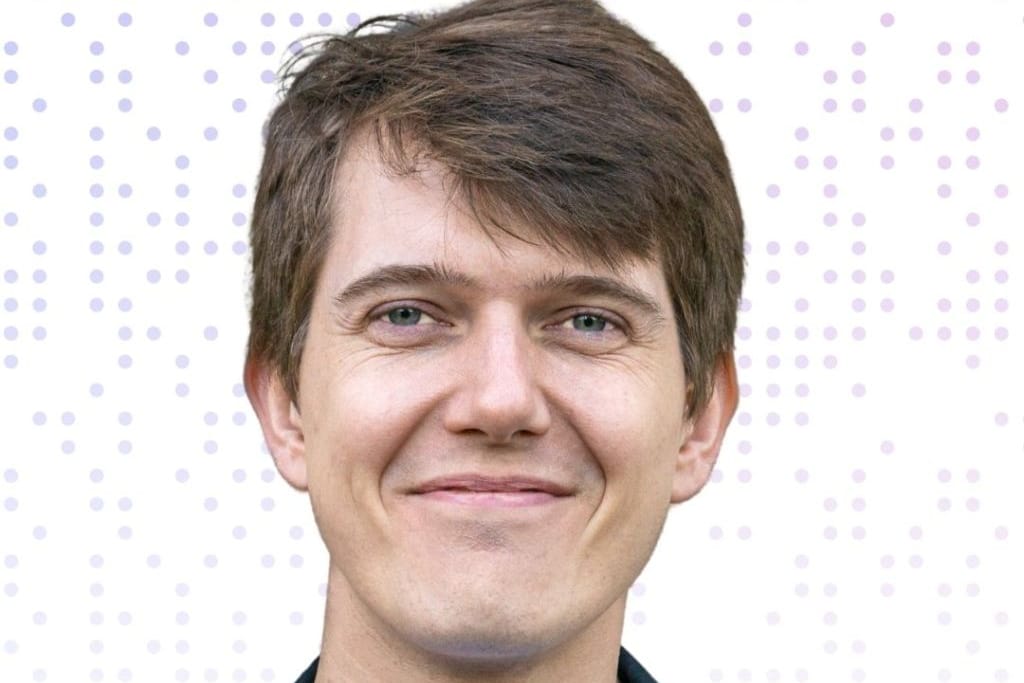

Nick Moës von der Organisation The Future Society hat den Entstehungsprozess des KI-Gesetzes hautnah miterlebt und nimmt als Vertreter der Zivilgesellschaft am aktuellen Kodex-Verfahren teil. Im Gespräch mit t-online erklärt er, warum die Verzögerung problematisch ist und welche Folgen ein Scheitern für deutsche Verbraucher hätte.

t-online: Herr Moës, warum ist es so wichtig, KI zu regulieren?

Nick Moës: Derzeit erfolgen die Entwicklung und der Einsatz von KI ohne angemessene Kontrollen und Abwägungen. Legitimität und Rechenschaftspflicht sind bei KI-Technologien von entscheidender Bedeutung, denn sie werden die Zukunft unserer Welt maßgeblich mitgestalten. Wir können uns nicht darauf verlassen, dass ein schnelllebiges industrielles Wettrüsten dem öffentlichen Interesse dient. Deshalb muss eine wirksame KI-Governance jetzt Priorität haben.

Beobachter sprechen von einer “epischen Lobbyschlacht” um den KI-Verhaltenskodex. Sie sind mittendrin in Brüssel – was genau geht da vor sich?

Diese Unternehmen betreiben einen ungewöhnlich hohen Aufwand, um den demokratischen Prozess zu beeinflussen. Und sie investieren dafür auch viel Geld. Die großen Tech-Konzerne wie Meta, Google und Microsoft versuchen, die unabhängigen Experten und die Europäische Kommission unter Druck zu setzen. Sie wollen von der vereinfachten Durchsetzung durch den Code of Conduct profitieren, aber gleichzeitig weiterhin unsichere Produkte auf dem EU-Markt verkaufen dürfen.

Das ist ein heftiger Vorwurf. Lässt sich der auch belegen?

Es gibt ein Transparenzregister, und Organisationen wie Transparency International und das Corporate Europe Observatory dokumentieren diese Ausgaben. Daran lässt sich erkennen: Die größten Unternehmen der Welt bezahlen Berater, die mit den richtigen Politikern sprechen und die Regulierung in ihrem Sinne gestalten wollen. In Brüssel ist das eine typische Methode zur Beeinflussung von Gesetzen.

Nick Moës ist geschäftsführender Direktor von The Future Society, einer gemeinnützigen Organisation, die sich auf die Politik im Bereich der allgemeinen Künstlichen Intelligenz (General-Purpose Artificial Intelligence, GPAI) konzentriert. Er ist Wirtschaftswissenschaftler mit Sitz in Brüssel und spielte eine aktive Rolle bei der Ausarbeitung des AI Acts der EU und dem Aufbau seiner Durchsetzungsmechanismen.

Mit welchen Argumenten versuchen die Unternehmen, die Regeln zu schwächen?

Zunächst einmal: Nicht alle Tech-Unternehmen wollen schwächere Regeln. Gerade die innovativeren kleineren Firmen wie Mistral, Anthropic oder auch deren Investoren sagen öffentlich, dass sie die KI-Verordnung durchaus praktikabel finden. Es ist deutlich günstiger, wenn sie den standardisierten Regeln des Verhaltenskodex folgen und dafür eine Art “Gütesiegel” bekommen –, als wenn sie selbst beweisen müssen, dass ihre KI-Systeme sicher sind.

Die haben ein ganz anderes Problem: Die Geschäftskunden vertrauen der Zuverlässigkeit und Sicherheit der großen Modelle noch nicht. Deshalb nutzen Unternehmen diese KI-Systeme nur zögerlich, sondern eher Studenten für die Hausaufgaben – aber die bringen kaum Geld. Meta ist besonders lautstark. Mark Zuckerberg hat sich schon immer schwer damit getan, Regeln einzuhalten – sei es in Bezug auf Datenschutz, Kartell- oder Urheberrecht. Diese “Erst machen, dann fragen”-Mentalität führt zu einer grundsätzlichen Abwehr gegen gesellschaftliche Erwartungen. Das Hauptargument: Die Regeln würden es teurer machen, Produkte in Europa anzubieten und die wertvollen Daten europäischer Bürger zu sammeln.

Experten warnen, dass Europa durch die Regulierung nur noch zweitklassige KI-Technologie bekommt. Was sagen Sie dazu?

Das hängt von der Risikobereitschaft ab. Microsoft hat beispielsweise Bing mit GPT-4 erst in Indien und Indonesien mit etwa zwei Millionen Nutzern getestet, bevor es nach Europa kam. Wenn Unternehmen die geschützten Testumgebungen nicht nutzen wollen, die der AI Act vorsieht, testen sie eben anderswo. Aber ist das wirklich ein Problem? Wir bekommen dann die finale, ausgereifte Version statt der fehlerhaften Testversionen. Die EU-Bürger sollten keine Versuchskaninchen für Big Tech sein.